Inteligencia artificial en la industria lingüística: valor añadido para nuestros clientes

© Picture by Slab Design Studio via Canva

Hoy vivimos tiempos difíciles. Las cosas están cambiando rápidamente en el mundo en general y en el sector de servicios lingüísticos en particular. La inteligencia artificial está cada día más presente en todos los ámbitos de nuestra vida y nuestro trabajo. ¿Cómo podemos adaptarnos y crear oportunidades para ayudar mejor a nuestros clientes?

Empecemos con algunas definiciones relacionadas con la inteligencia artificial en el sector lingüístico:

Traducción automática neuronal (NMT):

La traducción automática neural (NMT) es un método de traducción automática basado en redes neuronales artificiales que ha experimentado importantes mejoras en los últimos años. Antes de la llegada de la NMT, los motores de traducción automática se basaban en métodos estadísticos, que presentan más limitaciones y errores.

Postedición de traducción automática (MTPE):

La postedición de traducción automática (MTPE) se refiere a la revisión de un texto traducido automáticamente (producido por un motor NMT) por parte de un traductor profesional o un lingüista especializado. La labor del traductor en el proceso de postedición es diferente a la de otros tipos de revisión ya que tiene que tener en cuenta que la traducción la ha hecho una máquina, que no siempre es coherente y puede cometer errores culturales y contextuales.

Modelo de lenguaje de gran tamaño (LLM, por sus siglas en inglés, Large Language Model):

Un modelo de lenguaje de gran tamaño (LLM) es un modelo estadístico gigante que utiliza una gran cantidad de datos para producir contenidos. “Un modelo de lenguaje grande o LLM (siglas en inglés para Large Language Model), también llamado modelo de lenguaje de gran tamaño, es un modelo de lenguaje que consta de una red neuronal con muchos parámetros (normalmente miles de millones o más), entrenados en grandes cantidades de texto sin etiquetar mediante aprendizaje autosupervisado o aprendizaje semisupervisado”*. Algunos LLM son privados (como ChatGPT OpenAI) y otros son de código abierto.

*Fuente: Wikipedia

Prompt Engineering (ingeniería de instrucción):

” La ingeniería de instrucción (Prompt engineering) es el proceso de estructurar un texto que puede ser interpretado y comprendido mediante un modelo de inteligencia artificial generativa. Un prompt es un texto en lenguaje natural que describe la tarea que debe realizar una IA (inteligencia artificial).”*

*Fuente: Wikipedia

Ejemplos de ingeniería de instrucción:

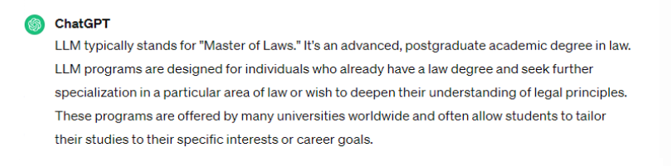

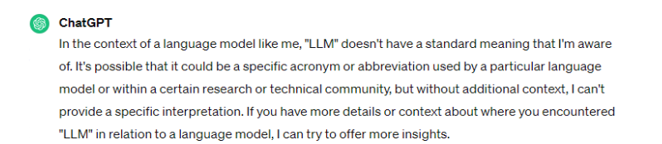

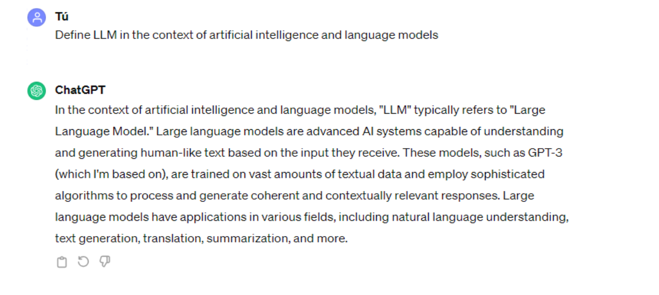

Si preguntamos simplemente a ChatGPT en inglés qué es un LLM, no nos da la respuesta esperada. Sin embargo, si luego le damos más contexto, el LLM acierta:

Cuando preguntamos a ChatGPT: “Dígame qué es un LLM”, obtuvimos la siguiente respuesta:

A continuación, preguntamos a ChatGPT: “¿Y en el contexto de un modelo lingüístico?” y obtuvimos la siguiente respuesta:

Alternativamente, podemos empezar por incluir más información en la pregunta inicial, lo que redundará en una mejor respuesta. Es lo que se denomina “ingeniería rápida”:

Inteligencia artificial generativa:

“La inteligencia artificial generativa o IA generativa es un tipo de sistema de inteligencia artificial (IA) capaz de generar texto, imágenes u otros medios en respuesta a comandos. Los modelos de IA generativa aprenden los patrones y la estructura de sus datos de entrenamiento de entrada y luego generan nuevos datos que tienen características similares.”*

*Fuente: Wikipedia

Veamos ahora algunas de las características de los LLM:

- Se basan en millones de segmentos.

- Pueden combinarse con memorias de traducción (MT) y traducción automática (TA) + glosario para tomar decisiones basadas en todos estos recursos.

- Dan más opciones a los traductores, lo que significa que la tarea de revisión es una parte crucial del proceso, la de la elección humana, y por lo tanto el traductor pasa a ser una pieza clave para mejorar la creatividad y la naturalidad de un texto.

- Podemos utilizar lenguaje natural para interactuar con los LLMs y recibir respuestas coherentes.

- Existen diferentes niveles de utilización de los LLMs:

- Ingeniería de instrucciones (no personalizable)

- Ajuste de modelos LLM con Python (modelos de código abierto)

- Crear nuestro propio LLM

Ahora que ya sabemos qué son los LLMs y cómo funcionan, veamos algunos ejemplos de casos reales para lo que pueden servir:

- Creación de glosarios: Permiten extraer términos de un texto para añadirlos posteriormente a un glosario. Incluso pueden añadir una definición para cada término.

- Reestructuración de archivos .srt (para subtítulos): Pueden convertir líneas segmentadas en frases reales en archivos .srt para que las herramientas TAO puedan procesarlas correctamente.

- Garantía de la calidad lingüística (LQA): Pueden analizar textos y realizar controles de calidad en distintos idiomas.

Así pues, los LLMs ofrecen muchas ventajas para la industria de los servicios lingüísticos, pero hay que tener en cuenta algunas advertencias:

- En el mundo hay unas 7.000 lenguas, pero los LLMs sólo han sido entrenados en unas 20, mayoritariamente en inglés, lo que significa que aún queda mucho camino por recorrer.

- Los LLMs pueden cometer errores, por lo que es primordial que los expertos en la materia revisen la información que generan.

- Dependiendo del LLM que utilicemos, deberemos tener en cuenta que cualquier información que carguemos se utilizará para entrenarlo y se perderá el control de la información confidencial.

Conclusión

Debemos convertirnos en expertos en inteligencia artificial (IA) para ayudar a nuestros clientes a implantarla en sus procesos. Tenemos que aprender a utilizar NMT, LLM y cualquier otra herramienta de IA que pueda hacernos más productivos, reducir costes y ayudar a nuestros clientes, en función de sus necesidades.

Si quieres saber cómo implantar la IA en tus procesos, envíanos un correo electrónico y analizaremos tu proyecto. Será un placer ayudarte.